Slop & AI-Slop

“Slop” (engl.: Fraß, Futterreste, Minderwertiges) ist ähnlich wie SPAM ein abwertender Ausdruck, der Online-Inhalte beschreibt, die salopp gesagt als “digitaler Müll” klassifiziert werden können. Das beinhaltet substanzlose, banale, austauschbare oder sogar fehlerhafte Inhalte, die in der Regel von einer KI generiert wurden und daher auch als “AI-Slop” bezeichnet werden.

Was ist Slop?

Mit dem Aufkommen und der verstärkten Nutzung von LLM (Large Language Model) wie ChatGPT oder Bildgeneratoren wie Midjourney, in den frühen 2020er Jahren wurde erstmals einer breiten Masse die Zugänglichkeit zu schnell erstellbaren Inhalten geschaffen. Arbeiten, die kreatives Talent erforderten und normalerweise per Hand mit Schreib- oder Bildbearbeitungsprogrammen erledigt wurden, konnten nun auch von Personen ohne Vorwissen erstellt werden. In Folge wurde das Internet mit fehlerhaften und substanzlosen Inhalten überschwemmt. Der Begriff “Slop” in seiner aktuell konnotierten Form wurde 2022 durch den Entwickler Simon Wilson geprägt, aber bereits zuvor schon erfolgreich auf Plattformen wie YouTube oder 4chan genutzt.

Das Wörterbuch Merriam-Webster definiert „Slop“ als „unwanted and unasked-for AI-generated content“ – also KI-Inhalte, die weder gewünscht noch erbeten sind. Es sind automatisch verfasste Social Media Posts, Blogbeiträge, generische Produktbewertungen, monotone YouTube-Videos mit synthetischen Stimmen oder Bilderserien, die von KI-Generatoren in Sekunden aus Textbefehlen entstehen.

Wie funktioniert Slop?

Der Zugang zur Erstellung von Slop-Inhalten ist denkbar niedrig. Schon mit frei oder günstig verfügbaren KI-Modellen lassen sich schnell Texte, Bilder oder Videos erzeugen – ganz automatisch und oft durch einfache Prompting-Techniken. Mit wenig Aufwand können so unglaubliche Massen an Slop generiert werden. Quantität vor Qualität.

Wenn ein Beitrag oder Bild ein paar Klicks oder Views bekommt, kann er sich auch finanziell lohnen, etwa über gezielte Werbung, eingebettete Affiliate-Links, Reichweitensteigerung oder Traffic. Deshalb werden Inhalte häufig nicht auf Qualität, sondern auf schnelle Sichtbarkeit und Engagement optimiert. Beliebte Slop-Inhalte drehen sich oft um Franchises, Fandoms, Prominente, Religion, Politik und den aktuellen Zeitgeist. Wo viele Menschen surfen, findet sich auch eine entsprechend bunte Bandbreite an Slop-Inhalten.

Diese Inhalte werden oft seriell erzeugt: Ein KI-Modell generiert mit jedem Befehl viele mögliche Varianten, wählt direkt die “guten” (nach vorgegebenen Parametern) Ergebnisse aus, publiziert sie automatisch – und idealerweise konsumiert oder teilt sie jemand, womit der Beitrag Reichweite erhält. Plattformen wie Facebook, Instagram, TikTok und Co., die Inhalte nach Engagement oder Sichtbarkeit sortieren, neigen dazu, solche generischen, schnell konsumierbaren Inhalte zu bevorzugen, weil sie oft besser performen als langfristig aufwendige Formate. Dadurch werden Slop-Inhalte stärker verbreitet und sichtbar.

Warum ist Slop gefährlich?

Slop erodiert die Informationsqualität und macht echten Journalismus unsichtbar. Relevante, gut recherchierte Inhalte werden aus den Feeds und unserer Wahrnehmung mehr und mehr verdrängt oder gehen in der Masse von Belanglosem und Oberflächlichem unter. Wer unter all dem Slop etwas Verlässliches finden will, braucht oft Geduld und eine gehörige Portion Digital- & Medienkompetenz. Inhalte, die von einer KI generiert wurden, enthalten oft Fehler, Ungenauigkeiten oder schlicht falsche Aussagen (sogenannte Halluzinationen).

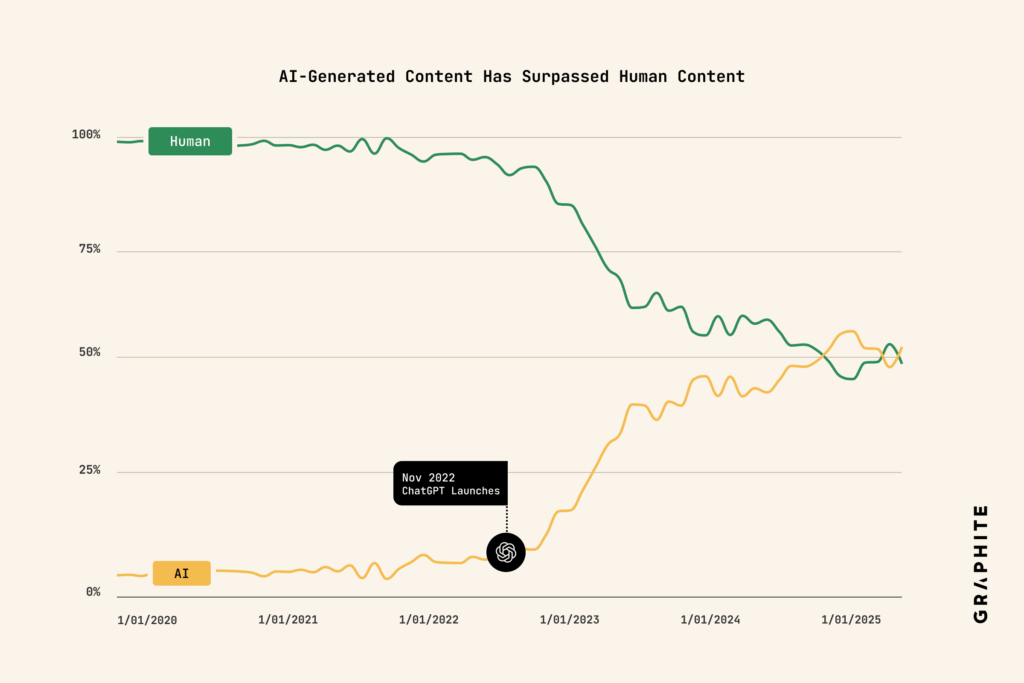

Der aktuelle Bad Bot Report von 2025 kommt zu dem Ergebnis, dass inzwischen nur noch 49% der Internetuser*innen echte Menschen sind. 14% sind sogenannte Good Bots wie z.B. ChatBots oder Bots, die Threads auf Microbloggingdiensten zusammenführen. 37% machen inzwischen die Bad-Bots aus – also auch diejenigen, die das Internet mit Slop, Falschinformationen, Hass und Hetze überschwemmen. Eine andere Studie hat erhoben, dass die von künstlicher Intelligenz generierten Blogartikel die von Menschen erstellten seit November 2024 überschreiten.

Ein anderer Trend ist beispielsweise das durch KI erneute Kopieren von Comics (Copyrightverletzung), durch KI erneute Erstellen und aus Fremdsprachen Übersetzen von Comics, oder das Erstellen von Bilderwitzen. Wenn solche Inhalte weit verbreitet werden, wächst das Risiko, dass Nutzer*innen falsche Informationen als echt wahrnehmen und sie in ihren Netzwerken teilen.

Wenn immer mehr von einer KI generierte mangelhafte Inhalte und Falschinformationen verbreitet werden, führt das zu Feedbackschleifen in den KI-Trainingsmethoden, da sie naturgemäß von den Modellen im Netz gefunden und zum Training herangezogen werden. Das kann zu einem sogenannten „Model Collapse“ führen, bei dem die KI-Modelle zunehmend weniger Vielfalt liefern und sich in eine Schleife aus sich selbst reproduzierender Mittelmäßigkeit stürzen („digitaler Inzest“).

Die Folgen reichen also weit über ästhetische Ermüdung hinaus. Im Angesicht der Klimakrise ist vor allem der ökologische KI-Fußabdruck bedenklich und erwähnenswert:

Jede KI-Anfrage, jede Bildgenerierung, jeder automatisch erstellte Text verbraucht Energie. Die riesigen KI-Datenzentren müssen gekühlt, Server betrieben und Modelle trainiert werden. Daten zeigen, dass die CO₂-Bilanz mancher KI-Systeme der mehrerer Flugreisen entspricht. In einem Artikel der Stanford University heißt es, dass das Training eines „off-the-shelf“ KI-Sprachverarbeitungssystems im Experiment etwa 1.400 Pfund (≈ 635 kg) CO₂ emittiert hat — das entspricht dem CO₂-Ausstoß einer Person bei einem Hin- und Rückflug von New York nach San Francisco. Eine aktuelle Studie quantifiziert, dass bei 79 KI-Systemen, die zwischen 2020 und 2024 veröffentlicht wurden, die jährliche CO₂-Äquivalenz der Top-20 Systeme bis zu 102,6 Mio. Tonnen CO₂e pro Jahr erreichen könnte.

Der Informationsüberfluss wird zum Ressourcenverbrauch. Digitaler Matsch mit CO₂-Fußabdruck.

Do’s und Don'ts

- Slop-Inhalte an Plattformen melden, besonders wenn diese von Bot-Seiten und gehackten/übernommenen Accounts verbreitet werden

- Slop-Inhalte nicht weiter teilen, Moderator*innen in Gruppen und Seiten-Admins auf das Problem aufmerksam machen.

- Alleinstellungsmerkmale bieten, die nicht leicht automatisierbar sind – etwa Stil, Tiefe, Kontext, Originalität.

- Bewusstsein schaffen: Wer kritisch liest, wer Quellen prüft, wer echten Journalismus unterstützt, trägt dazu bei, den digitalen Raum wieder lebenswerter zu machen.

Dir hat der Artikel gefallen?

Zur Durchführung unserer Arbeit erhalten wir keine Förderung oder Gelder aus öffentlichen Mitteln. Druckkosten, Honorare und Dienstleistungen der Medienschaffenden müssen mit den bestehenden Geldern der Organisation finanziert werden. Wir sind daher auf eure Spenden angewiesen.

„Der goldene Aluhut“ ist eine gemeinnützige Organisation.

Um uns zu unterstützen, und uns somit die Aufrechterhaltung unserer Arbeit zu ermöglichen, nutze bitte unser PayPal-Spendenkonto (oder sende deine Spende direkt an: spenden@dergoldenealuhut.de).

Spenden bis 300€ bedürfen keiner Spendenquittung. Bei Beträgen ab 300€ kontaktiert uns bitte für eine Spendenquittung.

Ihr könnt uns auch mit einer Steadymitgliedschaft unterstützen:

https://steadyhq.com/de/aluhut/

Für Steadymitgliedschaften können keine Spendenquittungen ausgestellt werden.